티스토리 뷰

기본 미션

2. 로지스틱 회귀가 이진 분류에서 확률을 출력하기 위해 사용하는 함수는 무엇인가요?

1. 시그모이드

시그모이드 함수는 선형 방정식의 출력을 0과 1사이의 값으로 압축하여 이진 분류를 위해 사용한다.

04-1 로지스틱 회귀

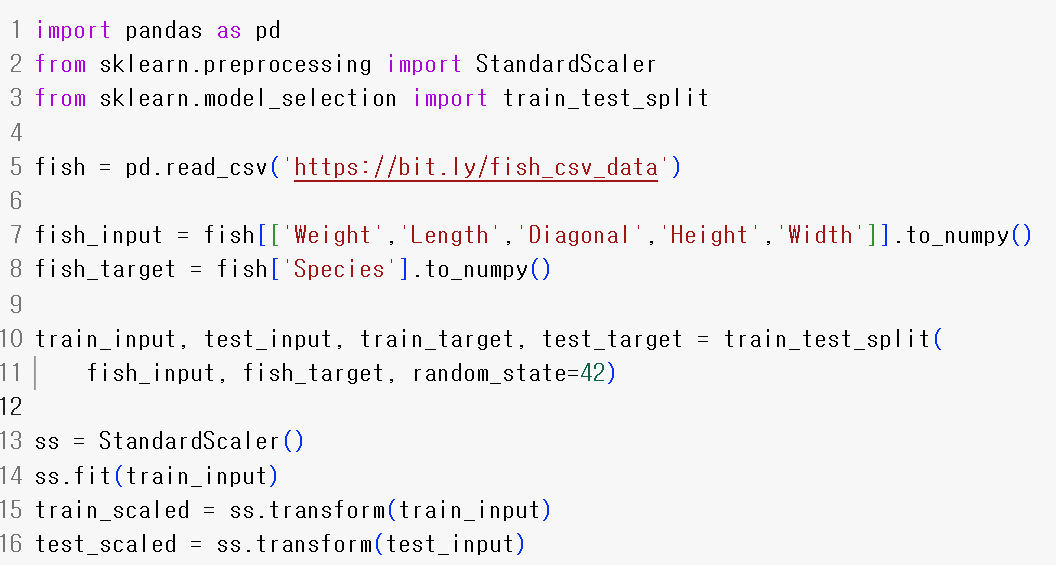

데이터 준비

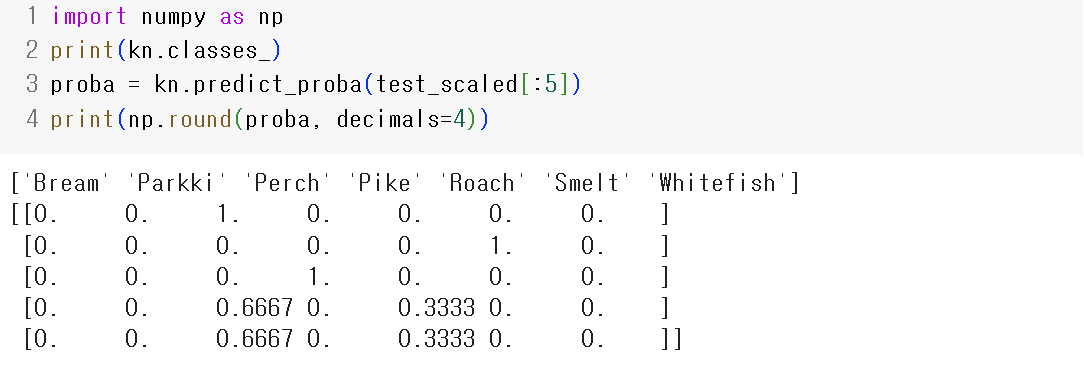

k-최근접 이웃 분류기의 확률 예측

- 7개의 생선 종류를 맞추는 문제

- 다중분류: 2개 이상의 클래스가 포함된 문제

- 3개의 최근접 이웃을 사용하기 때문에 확률이 0, 1/3, 2/3, 1으로 모두 같다.

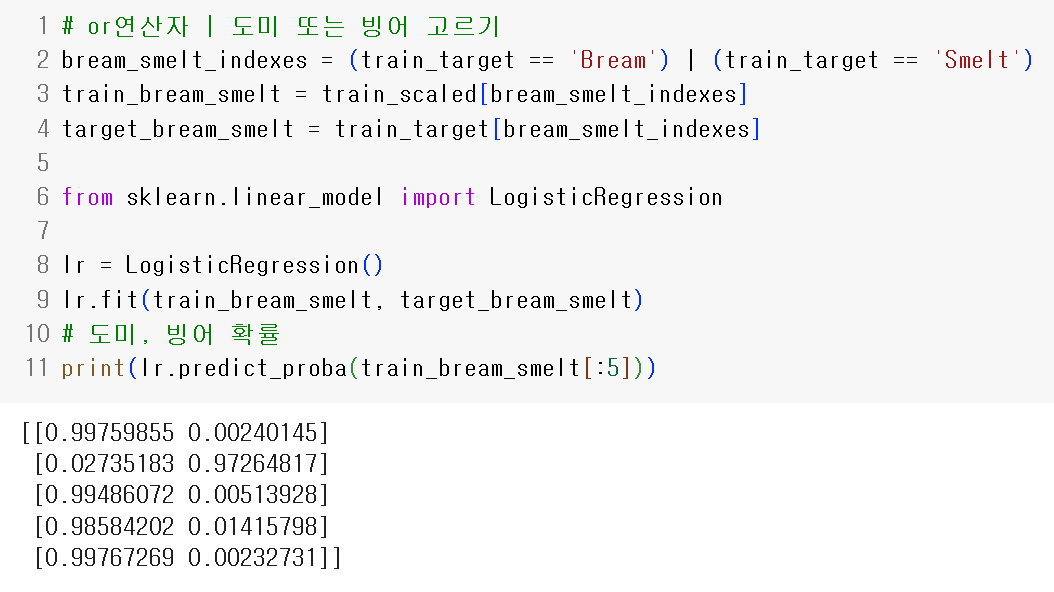

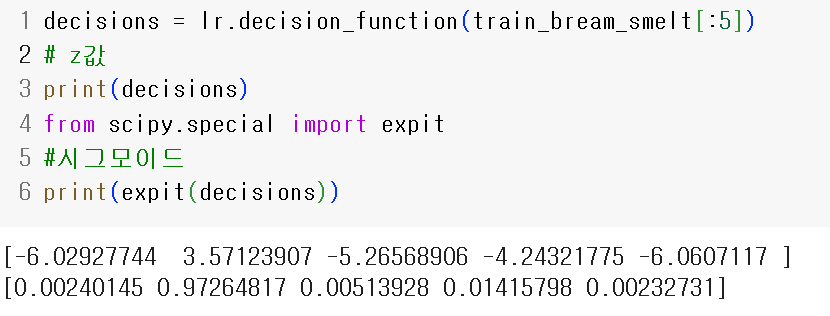

로지스틱 회귀

- 로지스틱 회귀: 회귀이지만 분류 모델로 선형 회귀처럼 선형 방정식을 학습

- 시그모이드: 0~1 사이의 값으로 바꾸는 함수

로지스틱 회귀로 이진 분류 수행하기

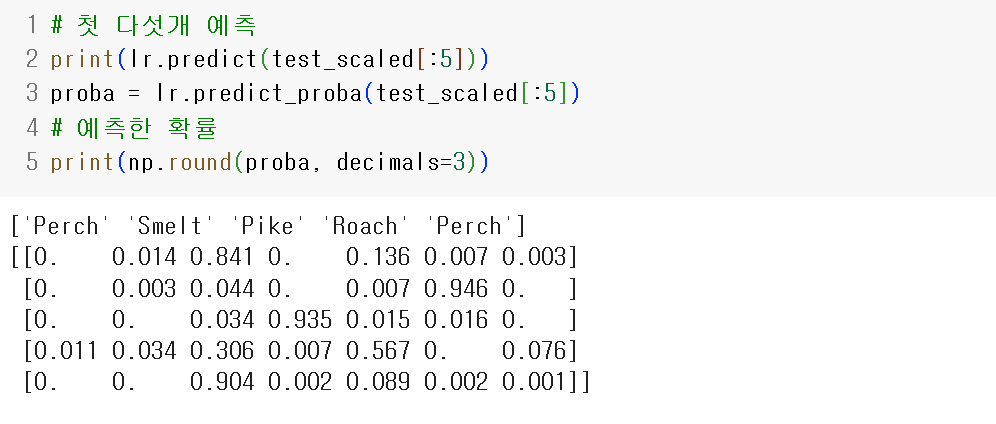

로지스틱 회귀로 다중분류 수행하기

z값에 소프트맥스로 확률을 구한 것과 같은 결과

04-2 확률적 경사 하강법

- 확률적 경사 하강법: 훈련 세트에서 샘플을 하나씩 꺼내 손실함수의 경사를 따라 최적의 모델을 찾는 알고리즘

- 손실함수: 확률적 경사 하강법이 최적화할 대상

ex) 이진 분류(로지스틱 회귀, 이진 크로스엔트로피), 다중 분류(크로스엔트로피), 회귀(평균제곱오차) - 에포크: 전체 샘플을 모두 사용하는 한 번 반복, SGD는 일반적으로 수십 수백번 반복

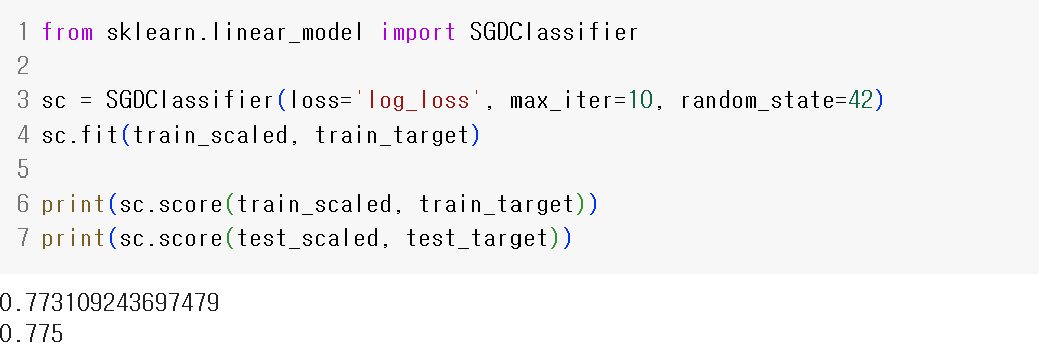

SGD Classifier

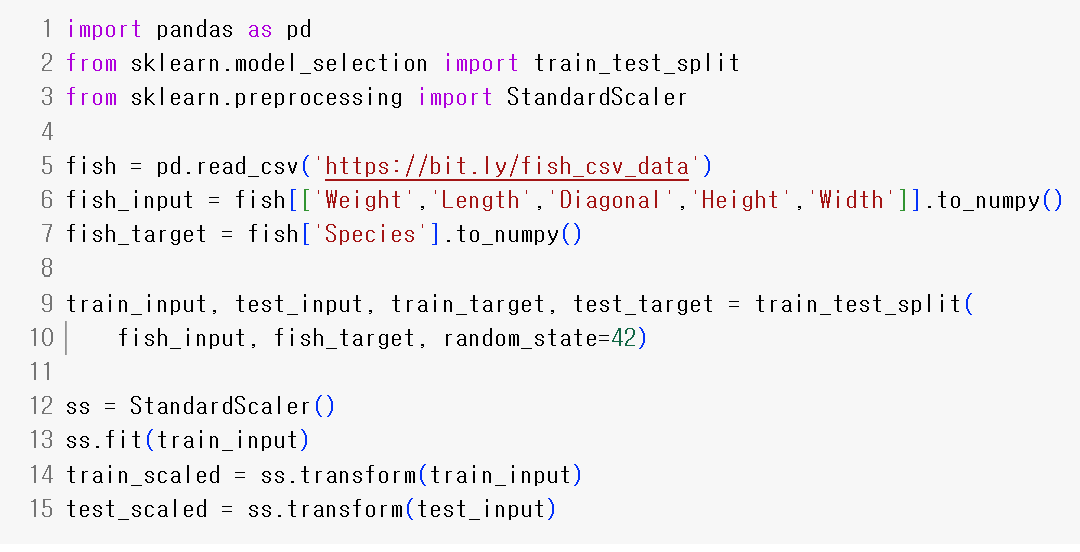

데이터 준비

모델

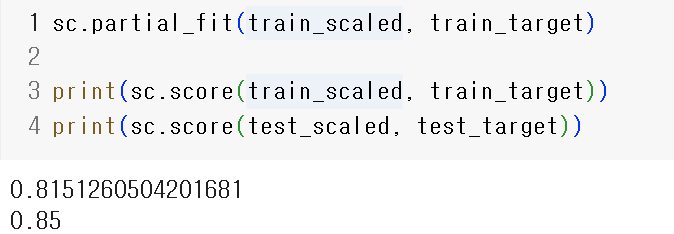

partial_fit으로 1에포크 추가 학습

에포크와 과대/과소적합

- 300 에폭 후 그래프

- log_loss

- hinge loss

'혼공단' 카테고리의 다른 글

| [혼공족] 혼자 공부하는 머신러닝 + 딥러닝 5주차 Ch06 (0) | 2024.01.28 |

|---|---|

| [혼공족] 혼자 공부하는 머신러닝 + 딥러닝 4주차 Ch05 (0) | 2024.01.26 |

| [혼공족] 혼자 공부하는 머신러닝 + 딥러닝 2주차 Ch03 (0) | 2024.01.12 |

| [혼공족] 혼자 공부하는 머신러닝 + 딥러닝 1주차 Ch02 (1) | 2024.01.07 |

| [혼공족] 혼자 공부하는 머신러닝 + 딥러닝 1주차 Ch01 (0) | 2024.01.04 |